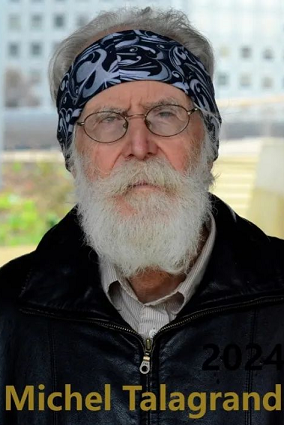

2024年的Abel奖颁给了法国著名数学家Michel Talagrand,以表彰他在概率论、泛函分析、理论物理等领域里做出的开创性工作。在当今在世的数学家中,很少有能像位出生于1952年的法国数学家那样具有如此巨大的分量和影响力。Abel奖由挪威政府在2002年Abel诞辰200周年的时候开始颁发,很快成为数学界的顶级奖项。这个每年颁发的奖项至今已经有20多个获奖者。笔者以为以Talagrand的成就和影响力,他至少在10年以前就应该获得这个奖项了。除了Abel奖,Talagrand在其职业生涯中还获得了Loève Prize (1995), Fermat Prize (1997)和邵逸夫奖(2019)。我们相信,随着机器学习和机器智能领域的蓬勃发展,Talagrand在高维概率论方面做出的一些奠基性工作及其思想影响力,将会更加彰显出来。

Talagrand生来就有视网膜薄弱的遗传倾向。五岁时,他因视网膜病变失去了右眼视力。在15岁生日之前,他的另一只眼睛也出现了视网膜脱离,而且治疗后又复发了几次。在他住院失学期间,作为数学教授的父亲帮他补习数学。高中时,他在全法国奥数和奥物的竞赛中都获得了第三名,并于20世纪70年代进入了巴黎著名的高等师范学院。在大学求学时期,他对概率论和测度理论产生了深深的迷恋,这一领域后来成为他职业生涯的基石。在研究生期间,他跟随Choquet教授解决了一些测度论方面的具体小项目。Choquet教授也给了足以影响他整个研究生涯的建议:“在有意义的情况下,用最简单的结构研究每个问题”。

在他的研究生涯早期,Talagrand对测度集中不等式的研究领域做出了重大突破,使之成为理解高维随机过程行为的有力工具。他在这一领域的工作为概率论及其在机器学习、统计学和计算机科学等领域的应用奠定了基础。Talagrand最著名的成就之一是他证明了著名的等周不等式。他在20世纪80年代末建立的这一结果揭示了几何学和概率之间的深刻联系,证明高维高斯测度表现出显着的集中现象。这项开创性的工作为更好地理解高维空间中随机过程的行为铺平了道路,这是现代数据分析和机器学习中至关重要的理论基石。

除了概率论,Talagrand在泛函分析方面也取得了重大进展。泛函分析是数学的一个分支,涉及无限维向量空间及其相关算子的研究。Talagrand在这一领域的代表性成果包括以他名字命名的凸不等式以及一些重对数定律,这些工作揭示了概率论与Banach空间理论和算子代数之间的深刻联系。

1995年以后,Talagrand的学术兴趣转向了自旋玻璃理论。在Giorgio Parisi的开创性工作的基础上,Talagrand阐明了自旋玻璃模型的平均场行为。这为Parisi的复制对称破缺方法提供了严格的数学基础,彻底改变了对自旋玻璃的理解。Talagrand严谨的数学分析技术在确定Parisi解决方案的有效性及其对热力学极限下旋转玻璃系统行为的影响方面发挥了至关重要的作用。

Talagrand自认学习数学的风格是非典型的。对于每个问题和数学分支,他都会把它拆成很多小块,然后反复琢磨,消化它们一千次。如此一直到他觉得自己对那个问题和分支有了真正理解,能够培养起足够的直觉去发展自己的想法。这样通过思考来学习数学的过程往往是比较漫长的,会使得系统地学习一个个数学领域变得很困难。但是正是这种方法保证了他真正能清本溯源,掌握最本质的基础知识,最终能够达到了傲视群雄的水平。

在现代数学史上,Talagrand是一位杰出的先驱者,他的开创性工作重塑了我们对概率论及其与其他数学分支的联系的理解。他引领发展的一些高维几何和概率论的理论,大大扩展了我们量化和推理随机事件的工具箱,能够从看似无序的事物中提取秩序。他的工作在计算机科学、工程和物理学等多个领域产生了深远的影响。他的贡献激励了一代又一代的研究人员,并在概率论、泛函分析和其他数学领域的交叉领域开辟了新的探索途径。

测度的集中现象

在我们的日常生活中,我们经常遇到看似随机的情况——从掷骰子到股市波动。考虑同时抛一千枚硬币。虽然每枚硬币出现正面或反面的可能性相同,但所有硬币正面朝上的总数很可能非常接近500(平均结果)。随着硬币数量的增加,偏差变得越来越小。

这样的例子还出现在抽样等方方面面的领域中。在这种种看似不可预测的情况下,出现了有趣的“确定”现象。其背后支撑的理论基础正是概率论中的“测度集中现象”。从本质上讲,它表明在高维空间中,大多数概率测度往往集中在某些相对集中的区域,通常靠近某种平均行为,而不是均匀分散。而且随着维度的增长,偏离的可能性呈指数级下降。Talagrand对这一现象的本质做了很直观的总结:“当许多随机自变量相互作用,但是其中任何一个变量都没有太大影响的情况下,其整体变量的表现就基本上是个确定的常数(平均值)。”

在经典的概率论中,这一现象的具体例子就是几个版本的大数定律。自1990年代以来,由Talagrand引领发展出来的许多强有力的几何和概率的理论,如等周法、度量熵和测度不等式等复杂工具,不仅使得我们对测度集中现象背后的数学逻辑有了更深刻的认识,而且也发现测度集中现象比我们原先认识的要宽泛的多,也就有了更多的应用场景。这种对于“随机世界里的确定性”洞察对于理解复杂性具有深远的影响,从数据分析和算法到物理学和生物学——这是高维空间挑战我们低维直觉的深刻方式的深刻体现。

当我们添加更多维度或变量时,大部分概率会堆积在平均值附近,偏差和随机性几乎消失。这样一个非常直观规律的认知支配着涉及随机性或不确定性的大多数高维情况。对跨学科具有深远的影响。在机器学习中,它有助于解释为什么在处理图像或文本文档等非常高维的数据时,简单的平均值可以胜过复杂的模型。在计算机科学中,它揭示了为什么大多数困难计算问题的实例实际上平均来说很容易解决。生物学和进化也在相当程度上受这一集中度规律的支配,使得生物体保持相当好的适应能力,而不是偏离生存最佳状态太远。

普遍性:复杂性孕育简单性

在现实中我们会遇到许多不同的统计量,从一个物种之间身高、体重或其他生命统计数据的变化、股票的年度回报率、学生的考试成绩、物理系统的组成粒子的速度,等等,其概率分布都可以观察到钟形曲线形状。这种趋同的出现并不是因为物种的身体发育、交易利润、学生学习程度或恒星速度等不同现象之间存在任何“微观”联系,而是因为在所有这些情况下,“高水平”或“宏观”结构是一样的:即由许多独立因素的微小影响组合而成的复合统计量。一个大型复杂系统的宏观行为几乎完全独立于其微观结构,这是普遍性的本质。这种复杂复合随机变量假设简单、众所周知的分布的现象是普遍性的早期表现。面对集体、聚合的行为,成分分布的复杂细节变得可以忽略不计。

作为概率论先驱之一的Lindeberg用简洁的语言揭示了一个违反直觉的事实:当一个随机变量取决于许多独立成分的集体影响时,它的行为超越了它们各自分布的复杂细节,表现出复杂中诞生的非凡简单性。这一现象背后的理论基石就是著名的中心极限定理:许多独立且同分布的随机变量的总和经过适当标准化后,会收敛到正态分布,而不管各个被加数的具体分布如何。

中心极限定理为统计学的发展奠定了理论基石,保证了许多统计量和统计算法的有效性和准确性。但随着我们探索的继续,我们也对更复杂情况下的是否还存在着普遍性也有更强的期待和探索欲。Talagrand引领建构的许多概率论和高维几何领域里的工具使得我们能进一步深化这一概念,将普遍性扩展到总和和平均值之外更多的复杂情形,尤其是动态的随机过程。当复杂性以平滑、相互关联的方式构建时,依旧可以孕育出简单性和普遍性。各个组成部分的复杂细节被新兴的集体行为所掩盖,受普遍法则和限制分布的支配。

这一普遍性原则在各个领域都具有深远的影响。在物理学中,它有助于解释为什么某些宏观现象(例如气体的行为或量子系统中的能级分布)表现出普遍特征,在很大程度上与组成粒子的微观细节无关。在统计学和机器学习中,即使面对与理想化分布假设的偏差,普适性也支撑了某些估计程序和算法行为的稳健性。它还为动态随机过程理论和罕见事件建模的研究提供了有效信息。

自然的临界点:高维度的相变

在概率和随机性的巨大织锦中,出现了一种迷人的现象:存在不同的行为模式,被极薄的边界隔开,在这些边界上发生了戏剧性的转变。例如在经典热力学中,当温度升高超过沸点时水从液体转变为气体。在统计物理学中,铁磁材料中自发磁化的出现或气体凝结成液体。

这些被称为相变的关键时刻揭示了一个深刻的事实——即使在机会领域,秩序和混乱也可以共存,并被控制复杂系统命运的微妙临界点分开。这种行为通常是非渐近的,这意味着它出现在有限维度中,并且不依赖于无限数据或资源的限制参数或假设。它反映了高维对象或过程的内在属性,类似于在物理学、生物学等复杂系统中观察到的涌现现象。

对于这些在狭窄的数据点范围内在两个截然不同的状态的转变突然发生现象,我们的理解来自经典概率论中的0-1定律。考虑一系列独立、同分布的伯努利随机变量,每个变量代表一个二元结果(例如,正面或反面、成功或失败)。随着控制这些伯努利变量的潜在概率参数(p)增加,足够对称的布尔函数在其行为中表现出急剧的相变。低于p的临界阈值时,函数以高概率输出0(假),而高于阈值时,函数会突然翻转以高概率输出1(真)。这种从一个极端到另一个极端的突然非线性转变类似于经历相变的物理系统,p的临界值充当临界点,分隔两个不同的行为阶段或状态。

也正是基于Talagrand引领建构的高维概率论的一些工具,以及他在平均场理论方面奠基性工作,使得我们不仅对这种现象背后统一的概率机制有了更清晰的认知,而且也认识到这种相变不仅限于布尔函数,还体现在各种高维随机对象和统计过程中。在机器学习和信号处理中,相变表征了算法和估计程序的性能,根据数据量或信噪比揭示了它们表现出色或灾难性失败的情况, 而且这种从成功到失败的转变在狭窄的数据点范围内突然发生。相变的概念和由关键临界点分隔的不同行为机制的出现可以被视为与人工智能的最新发展有关,特别是在大型语言模型和基础模型的背景下。

随着人工智能系统,特别是那些基于深度学习和自注意力机制(例如Transformer)的系统,其规模和训练数据不断扩大,我们正在见证质量不同的能力的出现,这些能力似乎突然出现超过了一定的规模阈值。例如,OpenAI的ChatGPT和Google的PaLM等大语言模型已经表现出了惊人的自然语言理解、生成和推理能力,这是以前较小模型中未曾观察到的。当模型的性能跨越一定规模的参数计数和训练数据集大小时,模型的性能似乎出现了阶段转变。

基于此,一些研究人员假设,随着语言模型继续向更大的数据集和参数计数扩展,语言模型功能中存在进一步的关键阈值或阶段变化。推测包括如果跨越某些过渡点,可能会出现真正的理解、常识推理,甚至通用人工智能(AGI)。

虽然人工智能能力中这些推测的相变的确切性质和位置仍然未知,并且引起了激烈的争论,但其核心概念强调了一个有趣的可能性——就像自然界中的许多复杂系统一样,人工智能模型可能蕴藏着“临界点”,即智能发生质的转变和某些行为的突然显现。

发现和理解这些过渡机制可能会对人工智能开发路线图、资源分配策略、安全考虑以及我们对大型神经架构中智能本身的出现的基本理解产生深远的影响。当我们突破人工智能规模和复杂性的界限时,相变研究提供了一个丰富的概念镜头来推理突然、不连续的能力增益或风险的可能性。它提醒我们,在现代人工智能的高维领域,通往先进人工智能的道路可能会被分隔不同行为阶段的关键临界点所打断。这些都等待我们进一步的探索和发现。